地平线RDK实现智能循线机器人应用示例

功能介绍

巡线任务,即机器人小车能够自主跟着一条引导线向前运行,引导线往左,小车也跟着往左转,引导线往右,小车跟着往右转。该任务是轮式机器人中比较基础的任务,实现方式也有多种,比如:

通过安装多个光电传感器(灰度传感器),根据传感器的的返回值判断该传感器是否位于线上,进而调整机器人运动方向。

通过摄像头基于传统的图像处理方法如边缘检测等获取线在图像中的位置,进而调整机器人运动方向。

上述常用方法当光照环境、场地发生变化,一般需要反复通过采集图像调整阈值以及进行测试来实现比较好的识别结果。那有没有可能让机器人能够自行适应环境的变化,不再需要人为的调整阈值呢?卷积神经网络(CNN),是深度学习算法应用最成功的领域之一,具有不错的适应性和鲁棒性,近年来随着处理器的快速发展,已经可以在嵌入式端进行CNN推理,这里使用CNN的方式实现巡线任务中引导线的位置感知。

物料清单

以下机器人均已适配RDK X3

使用方法

准备工作

机器人具备运动底盘、相机及RDK套件,硬件已经连接并测试完毕;

已有ROS底层驱动,机器人可接收“/cmd_vel”指令运动,并根据指令正确运动。

机器人组装

以下操作过程以OriginBot为例,满足条件的其他机器人使用方法类似。参考机器人官网的使用指引,完成机器人的硬件组装、镜像烧写及示例运行,确认机器人的基础功能可以顺利运行。

安装功能包

1.参考OriginBot说明,完成Originbit基础功能安装

2.安装功能包

启动机器人后,通过终端SSH或者VNC连接机器人,点击本页面右上方的“一键部署”按钮,复制如下命令在RDK的系统上运行,完成相关Node的安装。

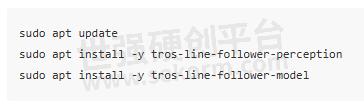

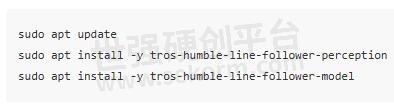

tros foxy版本

tros humble版本

3.运行巡线功能

tros foxy版本

source /opt/tros/local_setup.bash

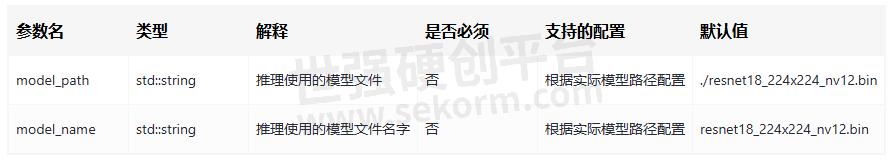

ros2 run line_follower_perception line_follower_perception --ros-args -p model_path:=/opt/tros/share/line_follower_perception/resnet18_224x224_nv12.bin -p model_name:=resnet18_224x224_nv12

tros humble版本

source /opt/tros/humble/local_setup.bash

ros2 run line_follower_perception line_follower_perception --ros-args -p model_path:=/opt/tros/share/line_follower_perception/resnet18_224x224_nv12.bin -p model_name:=resnet18_224x224_nv12

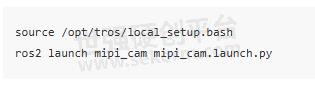

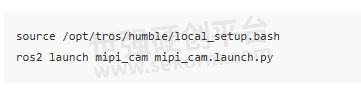

运行mipi_cam

tros foxy版本

tros humble版本

最后进入小车的运动控制package,originbot_base运行

tros foxy版本

tros humble版本

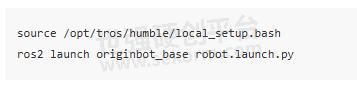

用PVC胶带搭建场景,巡线效果图如下图:

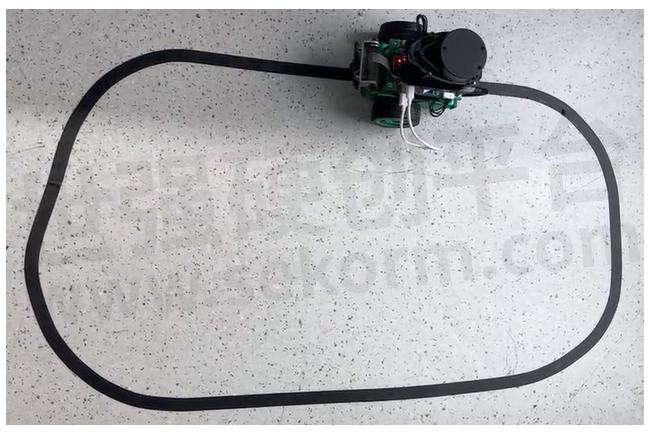

原理简介

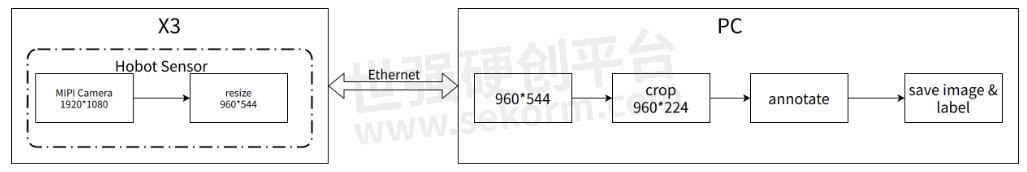

整套系统如上图所示,地平线RDK通过摄像头获取小车前方环境数据,图像数据通过训练好的CNN模型进行推理得到引导线的坐标值,然后依据一定的控制策略计算小车的运动方式,通过UART向小车下发运动控制指令实现整个系统的闭环控制。

PC用于进行数据标注以及训练,为了提高效率这里采用地平线RDK将图片通过以太网发送至PC端进行标注的方式。

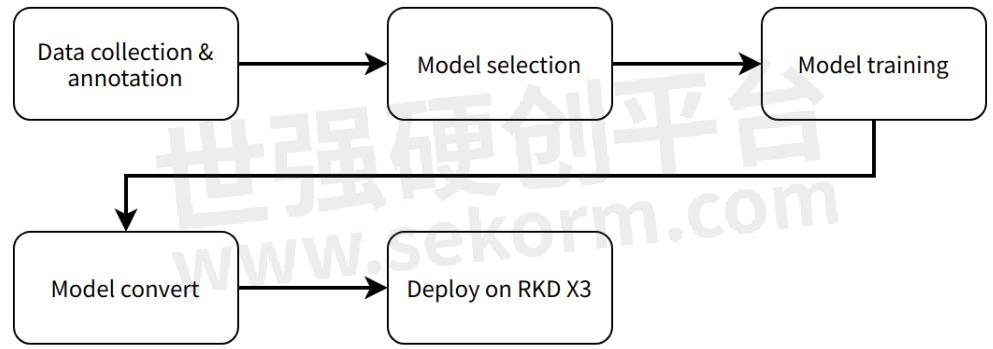

整个软件工程包括5个主要环节分别是:

数据采集与标注,根据任务目标获取相应的数据并进行标注,用于模型训练;

模型选择,根据任务目标选取合适的模型结构确保性能和精度都能够满足需要;

模型训练,使用标注的数据对模型进行训练,以达到满意的精度要求;

模型转换,使用算法工具链将训练得到的浮点模型转换为可以在地平线RDK上运行的定点模型;

端侧部署,在地平线RDK上运行转换后的模型,得到感知结果并控制机器人运动。

系统工作流程如下:

接口说明

话题

Pub话题

参数

- |

- +1 赞 0

- 收藏

- 评论 0

本文由雪飘梦飞转载自D-Robotics官网,原文标题为:智能循线机器人,本站所有转载文章系出于传递更多信息之目的,且明确注明来源,不希望被转载的媒体或个人可与我们联系,我们将立即进行删除处理。

相关推荐

RDK X3基于RDK X3的手势识别算法示例

手势识别算法示例订阅包含人手框、人手关键点信息的算法msg,利用BPU进行推理,发布包含手势信息的智能结果msg。手势识别算法集成了人手关键点检测,手势分析等技术,使得计算机能够将人的手势解读为对应指令,可实现手势控制以及手语翻译等功能,主要应用于智能家居,智能座舱、智能穿戴设备等领域。

RDK平台实现MIPI相机驱动的操作实例

本项目案例为对已适配的MIPI接口摄像头进行配置,并将采集的图像数据以ROS标准图像消息或者零拷贝(hbmem)图像消息进行发布,供需要使用图像数据的其他模块订阅。

基于RDK X3实现的语言大模型操作实例

hobot_llm是地平线RDK平台集成的端侧Large Language Model (LLM) Node,用户可在端侧体验LLM。目前提供两种体验方式,一种直接终端输入文本聊天体验,一种订阅文本消息,然后将结果以文本方式发布出去。

基于RDK X3操作思岚激光雷达驱动示例

SLLIDAR ROS2驱动,以ROS2标准消息格式发送激光雷达数据。

亚博智能RDK X3 ROBOT机器人项目实例,实现RKD X3 ROBOT的基本运动控制和位姿反馈

亚博智能RKD X3 ROBOT是一款面向机器人开发者和教育生态的智能机器人开发套件。该套件以旭日X3派为核心运算单元,以TogetherROS.Bot为核心机器人操作系统,集成成了建图、导航、人体跟随、手势识别等功能。本项目为亚博智能RKD X3 ROBOT机器人最小功能系统,该系统能够实现RKD X3 ROBOT的基本运动控制和位姿反馈。

YDLIADAR激光雷达驱动应用实例

介绍YDLIADAR激光雷达驱动的方案与技术要求,YDLIDAR ROS2驱动,以ROS2标准消息格式发送激光雷达数据。

于RDK X3设置USB摄像头驱动,实现采集图像数据和发布功能

本项目功能为hobot_usb_cam从USB摄像头采集图像数据,以ROS标准图像消息或者零拷贝(hbmem)图像消息进行发布,供需要使用图像数据的其他模块订阅。

OriginBot机器人最小功能系统的机器人底盘驱动应用实例

OriginBot是一款智能机器人开源套件,更是一个社区共建的开源项目,旨在让每一位参与者享受机器人开发的乐趣。该项目是OriginBot机器人最小功能系统,该最小系统可接受/cmd_vel指令控制机器人运动并反馈/Odom信息。

基于RDK X3 & Module的性能检测软件使用示例

Performance Node该应用基于Web网页打造,无论是什么品牌的电脑和手机,只需要在浏览器访问即可。

适配RDK X3实现Nav2移动机器人自主导航功能实例

自主导航功能贯穿了移动机器人大部分的运动过程,也是智能移动机器人中至关重要的一项基础技能,机器人可以根据地图信息,有效规划出行走的路径,还要通过激光雷达或者摄像头实时识别周围的障碍物,一旦出现意外的障碍,需要立刻做出避障的动作。

基于RDK X3的chat robot应用示例,实现用户和机器人语音聊天功能

智能语音聊天机器人识别用户语音内容,然后调用OpenAI API获取答复,最后将该答复播放出来,实现用户和机器人语音聊天功能。

2D垃圾检测应用示例

本Node是基于hobot_dnn开发的2D垃圾目标检测算法,采用PaddlePaddle开源框架, 利用PPYOLO模型进行垃圾检测任务设计和训练。为了达到快速部署的目的,本Node支持配置文件更换垃圾检测模型,开发者可以将更多精力投入在算法模型能力的迭代,减少部署工作量,识别输出的AI信息不仅可以通过话题发布,还可以在Web页面渲染显示。

智能语音聊天机器人功能及使用指南

智能语音聊天机器人通过识别用户语音,调用ChatGPT API获取答复并播放,实现语音聊天。需地平线RDK、ChatGPT API Key及音频板等物料。准备、组装后,安装功能包并运行,配置音频和ChatGPT API Key。常见问题包括设备连接、音频驱动、配置文件及网络访问等。

基于RDK X3开发板设计并实现的手持slam建图设计

这里使用RDK X3开发板设计并实现了一款SLAM手持建图设备,它使用RDK X3开发板的计算性能,通过激光雷达实现一个纯激光里程计,通过IMU对激光数据进行畸变矫正和对SLAM的姿态矫正,实现一个手持的SLAM建图功能。

乐动激光雷达驱动功能应用示例

乐动激光雷达驱动设计方案介绍,LDLIDAR ROS2驱动,以ROS2标准消息格式发送激光雷达数据。

电子商城

登录 | 立即注册

提交评论